2024年のノーベル物理学賞は、人工ニューラルネットワークによる機械学習の基礎技術を発明し、今日のAI(人工知能)時代を拓いたジョン・ホップフィールド名誉教授(プリンストン大学、アメリカ)とジェフリー・ヒントン名誉教授(トロント大学、カナダ)の2名に贈られました。彼らの功績について、理学院の大関真之教授に解説していただきます。

2024年のノーベル物理学賞の受賞理由を教えて下さい

大関 AIに関する発明にノーベル物理学賞が授与されたことを不思議に思う人も少なくないでしょう。AIの基本技術である機械学習は情報科学の分野であり物理学が相手にする自然現象とは相容れないように感じられます。まずは機械学習と人工ニューラルネットワークについて説明します。

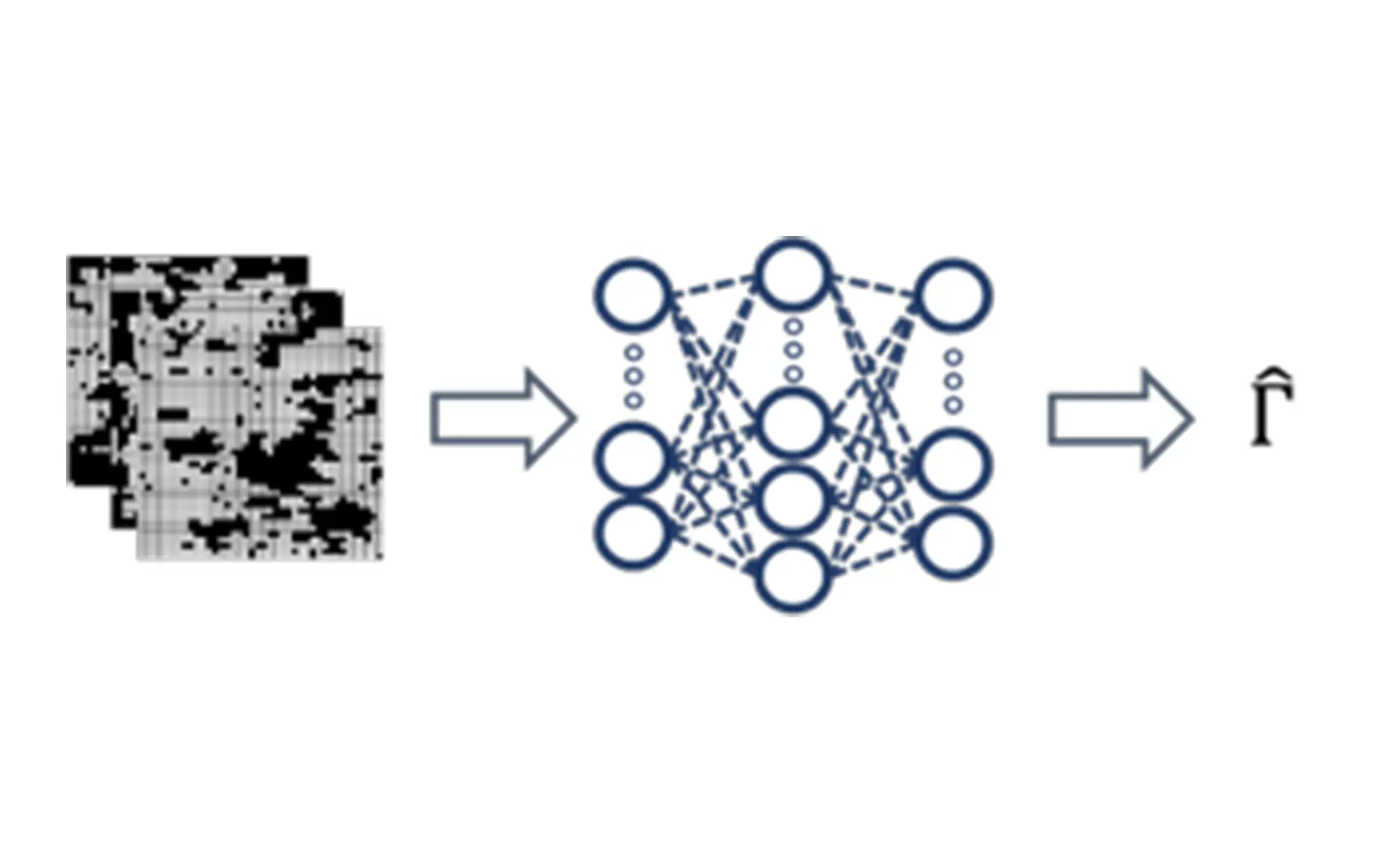

機械学習とは、コンピュータにさまざまなデータを読み込ませ、その特徴などを学習させる手法です。この機械学習を担うのが、生物の脳のしくみをコンピュータで表現した人工ニューラルネットワークです。脳のニューロン(神経細胞)は情報を信号として別のニューロンに伝達します。その際、ニューロン同士は結合しネットワークをつくります。たとえば、わたしたちが算数を学ぶ時、繰り返し同じ問題に取り組み「学習」します。繰り返し同じ情報に触れることで、ニューロン同士の結合が強くなり記憶され、同じ問題に出会った時に答えを思い出すことができるのです。

人工ニューラルネットワークでは、複数の人工ニューロンの間で信号を受け渡し、それらの信号に対して、どの信号がより重要かを判断する重みづけを行います。このような操作を繰り返すことで、人工ニューラルネットワークに学習をさせるのです。これを機械学習といい、AIはこの技術を使って学習しているため、データを与えるたびにより正しい答えを出力できるようになります。

ホップフィールド先生とヒントン先生は脳のネットワーク構造に着目し、それぞれ異なる人工ニューラルネットワークによる機械学習のしくみを発表しました。その結果、音声認識や画像認識、自動運転が実現し、この功績が認められノーベル物理学賞が授与されたのです。わたしたちがロボットやスマートフォンと会話できるのは、人工ニューラルネットワークによる機械学習のおかげです。

ホップフィールド名誉教授とヒントン名誉教授の人工ニューラルネットワークによる機械学習とはどのような研究なのか教えて下さい

大関 人間の頭脳を模擬することを目指して提案された人工ニューロンは、1943年にウォーレン・マカロックとウォルター・ピッツという2人の研究者によって考案されていました。しかし、学習能力が低く単純な問題しか識別できなかったため、人類の前に大きな壁が立ちはだかりました。ところが、1980年代に入り、「脳のニューロンはネットワーク構造なのだから、人工ニューロンもネットワーク構造にすればよいのではないか」と考えた研究者が現れました。それが、ホップフィールド先生とヒントン先生でした。

2人が提案した機械学習のアイデアのもとになったのは、物理学の一分野である統計力学のスピングラス理論です。原子には、スピンと呼ばれる性質があります。スピンとはスケートでもおなじみの回転のことで、複数の原子のスピンの向きがきれいに揃ったものが磁石です。一方、スピングラスはこのスピンの向きがバラバラの状態で固まった現象です。統計力学の分野では、スピングラス理論の微小な原子のふるまいをもとに、大きな現象を理解する研究がされてきました。複雑な物理システムの理解に画期的な貢献をした物理学者ジョルジョ・パリージ先生もスピングラスの現象を対象に、新しい解析手法を提案し、2021年のノーベル物理学賞を受賞しています。

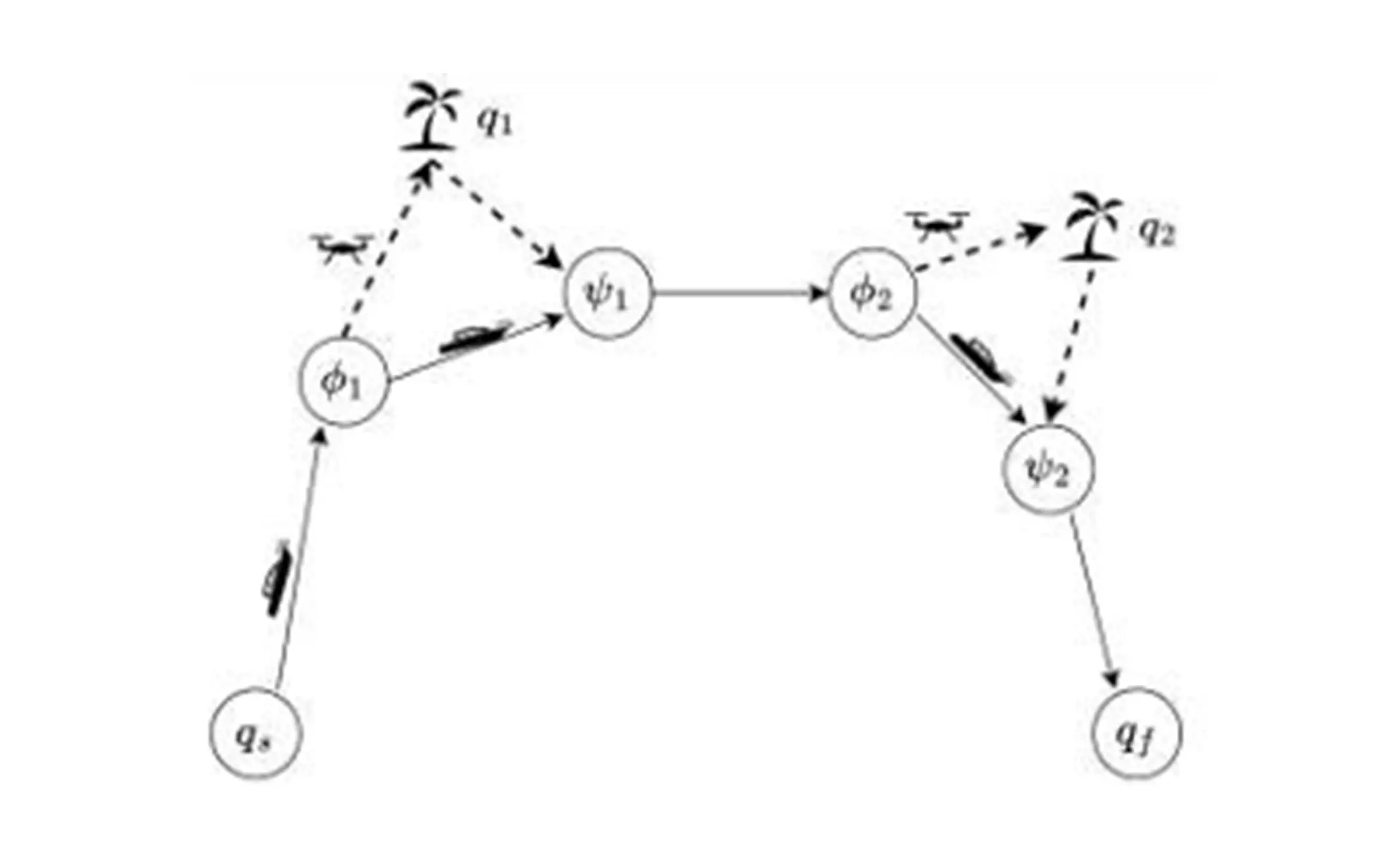

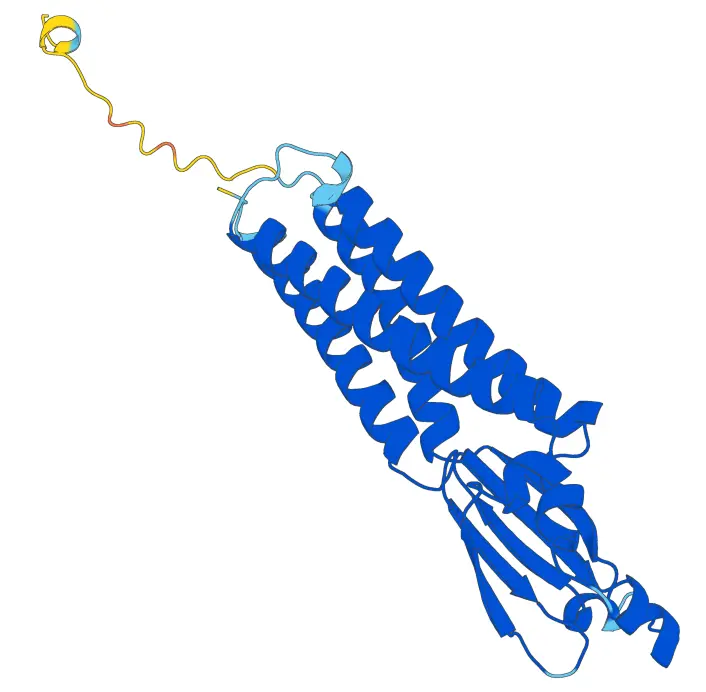

ホップフィールド先生とヒントン先生は、スピングラス理論を参考にそれぞれ異なる機械学習モデル(ネットワークのしくみ)を考えました。まず、1982年にホップフィールド先生が発表したのが「ホップフィールド・ネットワーク」です。ホップフィールド・ネットワークは、多数の人工ニューロンがさまざまな強さで結合したネットワーク構造をしています。この構造により、人工ニューラルネットワークに連想記憶を搭載できることを示しました。連想記憶とは、わたしたち人間のように記憶の一部から関連する事柄を思い出すことです。

ヒントン先生は、ホップフィールド・ネットワークと類似したもので、1985年に「ボルツマン・マシン」を提案しました。名前の由来は、統計力学の創始者の一人である物理学者ボルツマンを冠したボルツマン分布と呼ばれる統計力学を利用していることです。当初の学習方法では計算に膨大な時間がかかるため、実用化は困難と思われました。しかし、ヒントン先生らは改良を重ね、ネットワーク構造を工夫することで、新しい学習方法を提案しました。それが2000年代に発表された深層学習(ディープラーニング)の基礎になっています。深層学習は、機械学習の性能を著しく向上させ、今日の自然言語、画像、動画、音楽などを次から次へと生み出す生成モデルの活躍を導くに至りました。

大関教授のご研究との関係性について聞かせて下さい

大関 私の研究テーマはスピングラス理論を用いた量子コンピュータの研究です。原子のスピンがもつ2つの向きを、コンピュータでの0と1のビットとすると、コンピュータ科学でのさまざま問題はスピングラス理論で扱うことができます。私は学生時代、東京工業大学(現東京科学大学)で恩師の西森秀稔先生のもと、スピングラス理論に基づく「量子アニーリング」の研究に携わりました。量子アニーリングは、世界で初めて実用化された量子力学を動作原理に用いた計算技術であり、西森先生はその基本理論を考案した人物です[関連記事]。東京科学大学では、ホップフィールド・ネットワークを量子力学に基づき駆動させる「量子ホップフィールドモデル」の研究も進めています。AIや量子コンピュータに興味のある方はぜひ東京科学大学で、一緒に研究を進めていただきたいと願っています。

関連記事

*本記事は、2024年11月20日(水)にオンライン開催されたScience Tokyoノーベル賞解説講演会の内容をもとに制作しています。

大関教授の研究をもっと詳しく知るには

東京科学大学で行われている類似の研究

「2024年ノーベル賞を読み解く」シリーズ

お問い合わせ

研究支援窓口